7. Softmax regression

- multinomial logistic regression

: 여러 개의 클래스가 있을 때 예측, 그 중에서도 가장 많이 사용되는 softmax

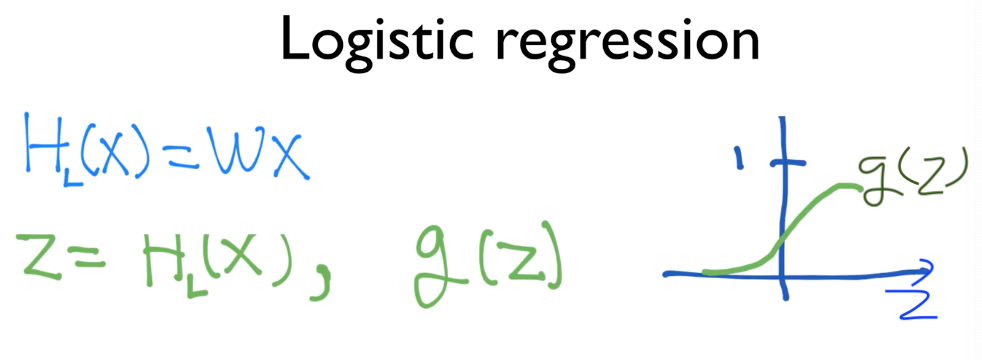

- 지난 포스트 정리

: binary classificaion

: z 가 아주 커지거나 아주 작아지더라도 g(z) 가 0과1 사이의 값을 갖도록 연구,

그래서 나온 것이 sigmoid 함수

: sigmoid함수를 이용해서 0-1 사이로 압축

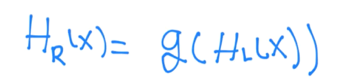

: 최종 hypothesis 는 이렇게 나타남

그림으로 정리,

: 입력 값 x 를 WX 라는 수식에 넣고, 나온 값인 z를 sigmoid 함수에 넣어 값을 도출

: Y 는 실제 데이터,

Y 햇은 예측 데이터(H(x))

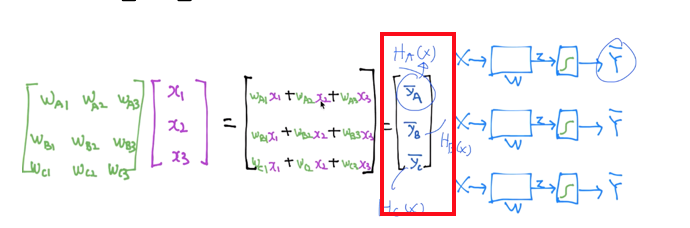

ex> 공부 시간, 출석 횟수에 따른 등급data set

: A, B, C 각각의 binary classification을 가지고도 구현이 가능

: matrix 곱이 됨

: 하나의 vector 로 3개의 독립된 classification 알고리즘을 구현!

: 각각의 sigmoid 모듈을 XA 햇, XB햇, XC햇에 적용하면 됨

-> 이것을 효율적으로 하는 방법이 존재

출처 : 모두의 딥러닝 https://hunkim.github.io/ml/

'AI & Deep Learning > 이론' 카테고리의 다른 글

| Logistic Classification Cost 함수 (0) | 2019.04.01 |

|---|---|

| Logistic Classification (Binary) (0) | 2019.04.01 |

| Multi variable linear regression (0) | 2019.04.01 |

| Linear Regression cost 함수 최소화 (0) | 2019.04.01 |

| Linear Regression 의 개념 (0) | 2019.04.01 |